CloudFilt: ¡Protege tu sitio web hoy mismo!

¿Cansado de bots, spam y clics sospechosos que arruinan tu ambiente y presupuesto? CloudFilt es el amigo callado que se conecta rápido, filtra la basura en tiempo real y te muestra exactamente lo que bloqueó para que tu sitio se mantenga limpio y rápido. Prender CloudFilt , mantén solo a personas reales y observa cómo esas visitas se convierten en ventas con menos estrés.

De amigo a amigo : algunos enlaces son enlaces de afiliados. Cuando compres, puede que la empresa me agradezca un poco sin ningún coste adicional. Solo recomiendo cosas que realmente he probado y investigado. Nada aquí es asesoramiento financiero; Es para entretenerse. Lee la divulgación completa de afiliados y la política de privacidad.

El tráfico de crawlers aumentó este año. Instalar CloudFilt en WordPress, observa los eventos en Monitor y luego aplica cuando el abuso sea evidente. Limpiarás los datos de GA4 rápidamente—y Puedes probar hasta 3.000 solicitudes gratis.

CloudFilt Te da un contraataque sencillo. Instalas un pequeño fragmento de código o el plugin oficial de WordPress, empiezas en Monitor para ver eventos y luego aplicas las reglas cuando estés seguro.

Está diseñado para equipos no técnicos e incluye una asignación gratuita para demostrar los resultados antes de comprar.

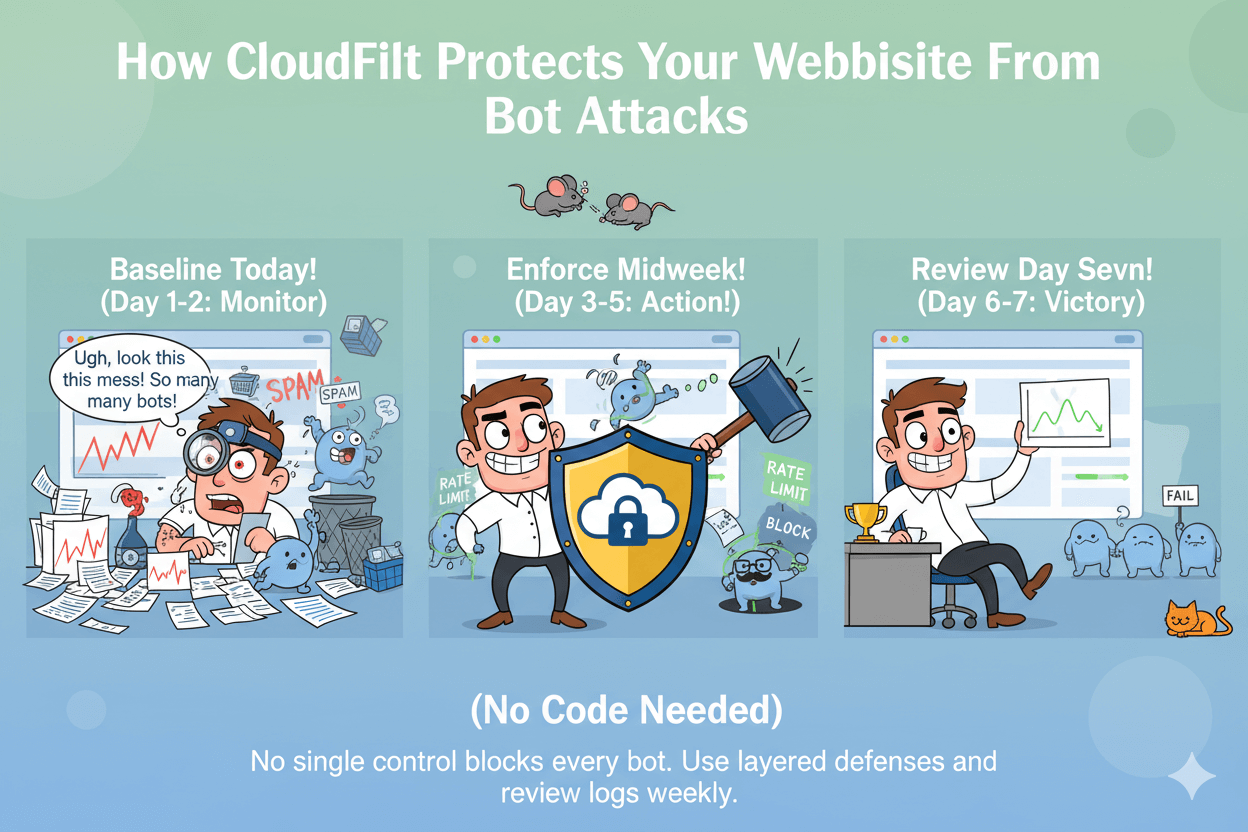

Esta guía te guía a través de una configuración sin código en WordPress, un plan de seis pasos para disuadir a los scrapers y una forma rápida de separar humanos de bots en GA4 para que tus decisiones dependan de datos limpios.

También verás por qué robots.txt no es suficiente por sí sola y cómo los valores por defecto de la industria se están desplazando hacia el bloqueo activo y las opciones de "Pago por Rastreo".

Aviso legal: Ningún control bloquea todos los bots. Usa defensas en capas y revisa los registros regularmente.

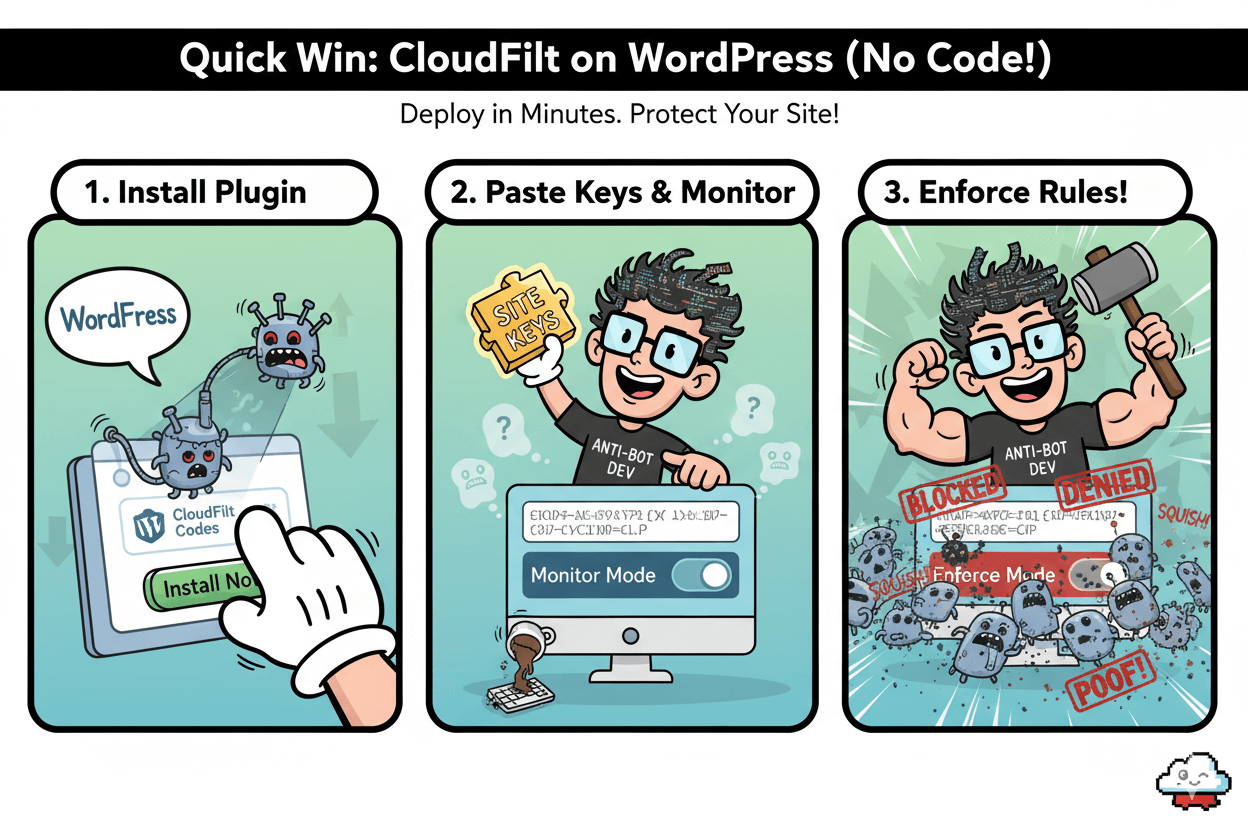

Victoria rápida: Configurar CloudFilt en WordPress (sin código)

Desplego en minutos. Empieza en Monitor y luego aplica cuando los eventos estén limpios.

Instala el plugin y pega tus códigos

Añadir el CloudFilt Códigos plugin de WordPress. Inserta el CloudFilt Códigos que permiten la protección contra bots, scrapers, envíos de spam y fraude en tu sitio.

Actívalo y luego pega las claves de tu sitio para conectar tu panel de control. El anuncio confirma el alcance y el estado actual del mantenimiento.

quick_win: Si usas WordPress.com o prefieres su interfaz, el mismo plugin está disponible allí con la versión, clasificación y detalles de la última actualización visibles antes de la instalación.

Activa los preajustes y comienza en modo Monitor

Abre tu panel de CloudFit. Mantén los presets activados, pero empieza en Monitor Así ves qué peticiones serían impugnadas o bloqueadas. Esto reduce la posibilidad de sobrebloquear al principio.

La página de integración de WordPress de CloudFilt documenta la ruta CMS y proporciona un enlace directo de "Descargar para WordPress".

myth_buster: No necesitas cambiar el código del tema. El plugin inyecta los códigos necesarios y CloudFilt analiza el comportamiento entre los flujos de tráfico front-end y back-end.

Verifica los eventos de tráfico antes de aplicar las normas

Estate atento a picos en las categorías de bots, golpes de scraper o envíos spam en tus eventos. Una vez que los patrones estén claros, cambia a Hacer cumplir para análisis de urinas, IPs o ASN abusivos. Este despliegue escalonado se alinea con los casos de uso de CloudFilt y los flujos de trabajo típicos de WordPress.

before_after: En las reseñas de usuarios, los equipos informan de reducciones rápidas en las visitas automáticas tras habilitar CloudFilt en WordPress, con una fricción mínima para los visitantes reales. Utiliza estas anécdotas como señales direccionales mientras validas en tus propios registros.

Ventana de prueba gratuita:

La página de precios de CloudFilt confirma una prueba gratuita de 3.000 solicitudes Con la mayoría de las funciones y sin tarjeta de crédito. Utiliza esta ventana para establecer métricas base, ejecutar Monitor, luego Enforce y comparar semana tras semana.

Aviso legal: Ningún control bloquea todos los bots. Empieza en Monitor, revisa los registros, luego aplica y ajusta.

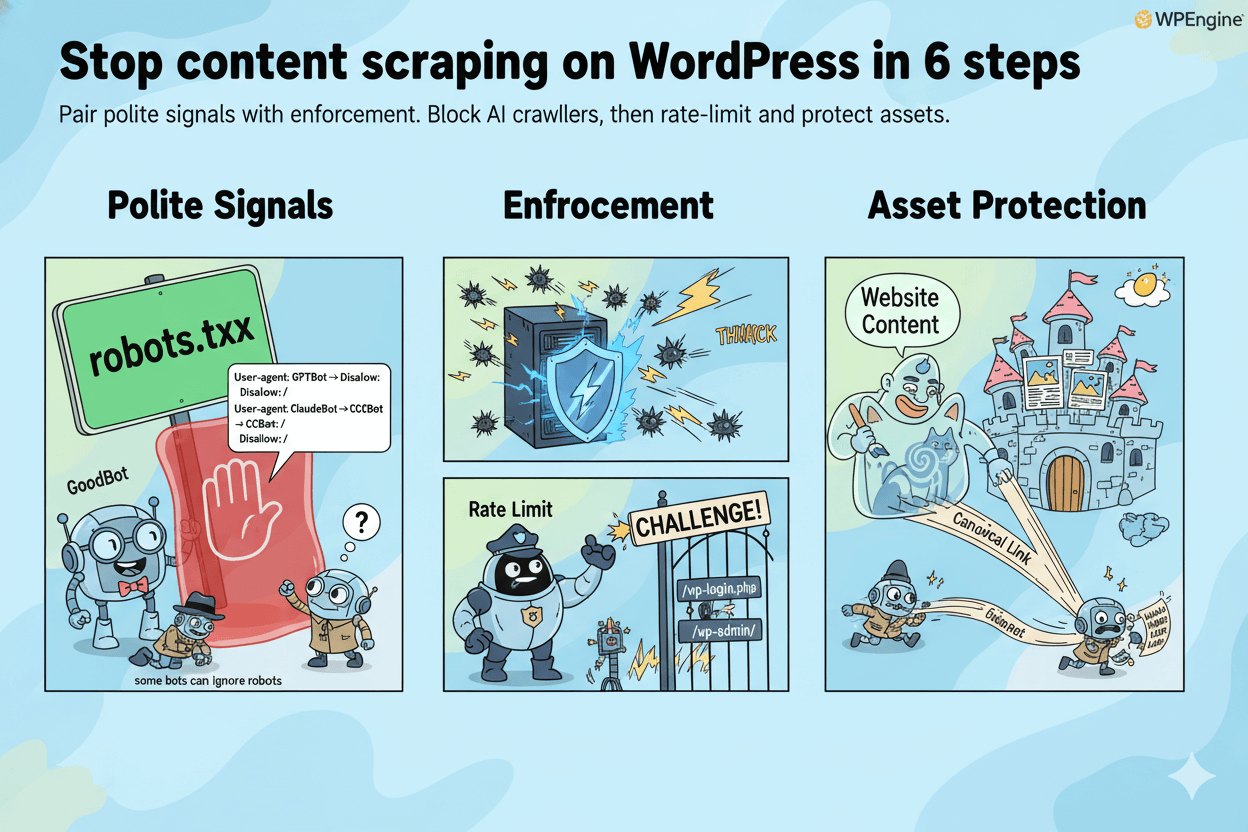

Detener el scraping de contenido en WordPress en 6 pasos

Combina señales educadas con la aplicación de la ley. Bloquea los rastreadores de IA, luego limita la tasa y protege los activos.

Bloquear rastreadores de IA mediante robots.txt y cabeceras

Empieza con controles educados. En robots.txt, prohíben rastreadores de IA conocidos como GPTBot , ClaudeBot y CCBot . Haz una copia de atrás con X-Robots-Tag o robots a nivel de página meta cuando necesitas reglas específicas de URL. Estas señales son fundamentales, pero dependen del cumplimiento de la oruga.

Ejemplos de líneas: User-agent: GPTBot → Prohibir:/ User-agent: ClaudeBot → Prohibir:/ User-agent: CCBot → Prohibir:/

Un toque de realidad: alguno Los bots pueden ignorar robots o enmascarar la identidad , así que la aplicación del plan es la siguiente.

Activar las reglas de bots y los límites de tasa suaves

Utiliza tu gestor de bots o WAF para impugnar peticiones repetidas, limitar IPs/ASN abusivos y bloquear UAs sospechosos en caminos de alto riesgo como /wp-login.php , /wp-admin/ , y los endpoints de sitemap o feed. Empieza de forma conservadora, observa los registros y luego aprieta.

Ahora los movimientos de la industria bloquean por defecto muchos rastreadores de IA, lo que subraya la necesidad de controles activos más allá de robots.txt.

pro_tip: Si un rastreador afirma cumplir con ello pero sigue bombardeando tu sitio, exige desafíos en patrones como ráfagas de peticiones altas o UAs headless, y rota listas de permisos solo para bots verificados y buenos. Los informes de "gateo sigiloso" muestran por qué las reglas basadas en el comportamiento son importantes.

Proteger imágenes y RSS contra el scraping copiado-pegado

Elimina el ancho de banda gratuito hacia los scrapers desactivando el enlace directo de imagen en el servidor/CDN. Añade marcas de agua para los visuales comerciales. Luego acorta o retrasa los extractos de RSS para que los clones no publiquen entradas completas más rápido que tú. Añade enlaces canónicos en plantillas para reforzar la propiedad.

Por qué funciona esto:

- Señales informar a los bots bien educados.

- Aplicación gestiona agentes que no cumplen.

- Controles de activos Corta rutas de copia fáciles y pérdida de ancho de banda.

Si tus registros muestran evasión (suplantación de UA, rotación de ASN), guarda pruebas y escala las normas. Algunos proveedores disputan acusaciones específicas, así que actúa con tus propios datos de tráfico mientras se desarrolla el debate.

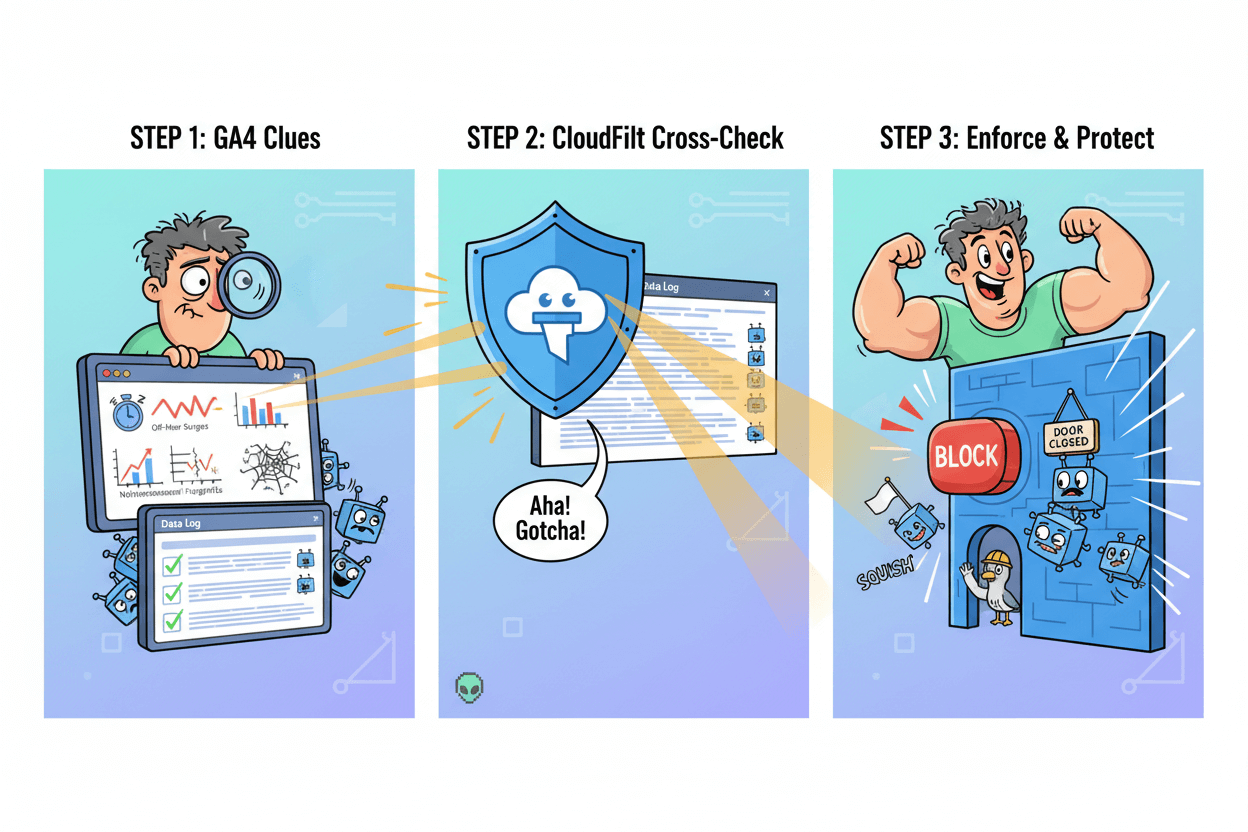

Contar bots de humanos en GA4

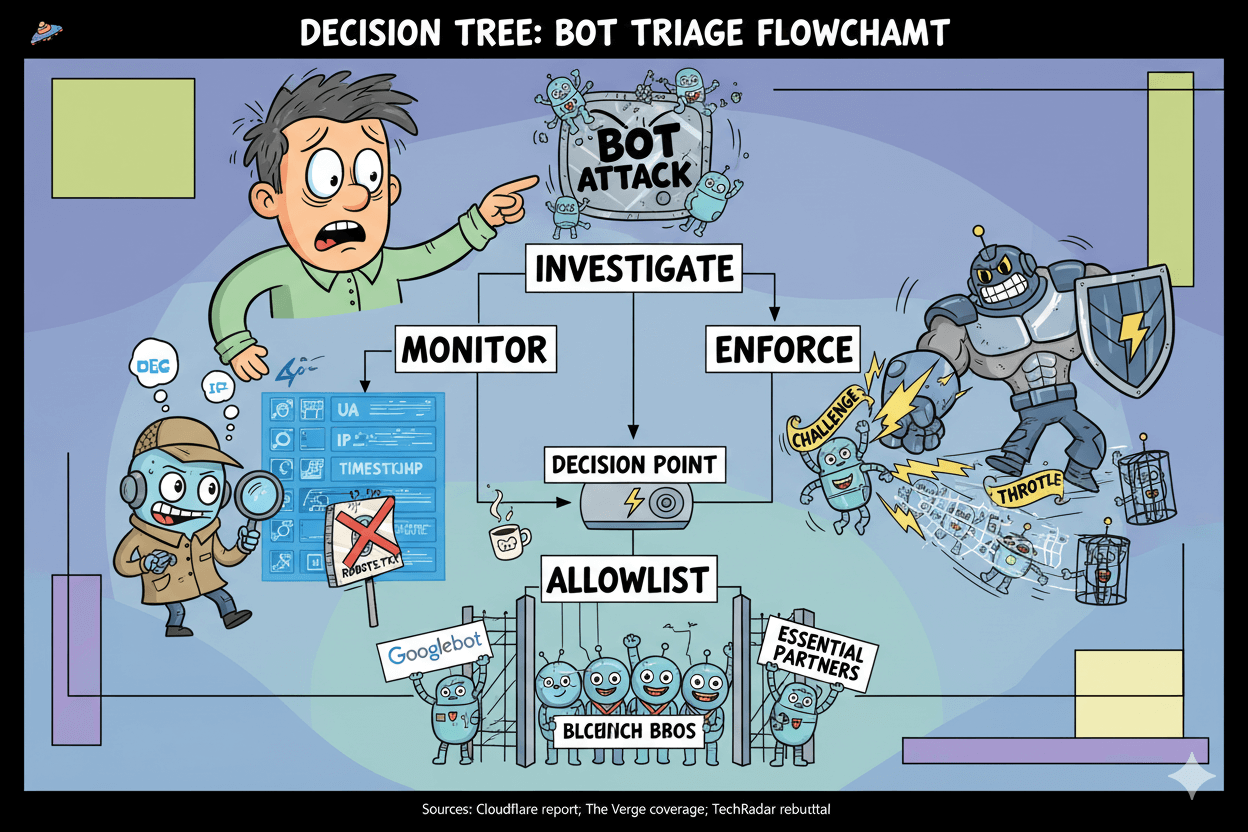

GA4 oculta bots conocidos, no todos. Utiliza segmentos de anomalía y verifica con los registros de CloudFilt.

Confirma la exclusión y límites conocidos de bots en GA4

GA4 excluye el tráfico clasificado como bots y spiders conocidos usando Google Research y la lista internacional IAB/ABC Spiders & Bots. Esto es automático y no configurable por el usuario.

Trátalo como una línea base, no como una solución completa, porque aquí solo se filtran los bots declarados o identificados.

micro_challenge: En Filtros de datos → de de datos → , activar filtros para Tráfico interno y Tráfico de desarrolladores Así que las visitas a la oficina y los resultados de depuración no contaminan tus cheques. Estos son a nivel de propiedad y no retroactivos.

Construir exploraciones y segmentos de señales de bot

Crear un Exploración que busca patrones similares a bots:

- Clústeres de cero compromiso: Sesiones con 0 visualizaciones, 0 tiempo de interacción o equivalentes al 100% de rebote por Fuente / Medio .

- Repuntes fuera de horario: A veces tu público rara vez visita un tráfico anormal.

- Huellas dactilares de red: Concentraciones por ASN (los números de sistema autónomo identifican grandes redes) o IPs repetitivas / secuenciales. Un ASN se mapea a la red enrutada de un solo operador, útil cuando se agrupan en clústeres de abuso.

- Rarezas de la UA: Agentes de usuario sin interfaz o obsoletos que siguen los mismos caminos.

Si necesitas una heurística rápida, escanea Fuente/Medio para cadenas que literalmente contienen "bot" y luego validan, ya que algunos tráficos de bajo esfuerzo se etiquetan a sí mismos.

Validación cruzada con eventos del panel de CloudFilt

Compara tus segmentos de GA4 con los registros del gestor de bots para asegurarte. Si CloudFilt muestra solicitudes repetidas del mismo ASN, rango de IP o UA sospechoso en rutas como /wp-login.php o feeds, probablemente hayas encontrado bots residuales que GA4 no excluyó automáticamente.

Esa es tu señal para Hacer cumplir reglas dirigidas mientras mantienen los segmentos de GA4 como un canario de detección.

Lo que s_and_don no hacer:

- Hacer documenta la evidencia ASN/IP antes de bloquear. No Bloquea rastreadores de confianza sin que tengan revisión.

- Hacer volver a probar tras habilitar las reglas; No espera que los filtros GA4 atrapan tráfico furtivo.

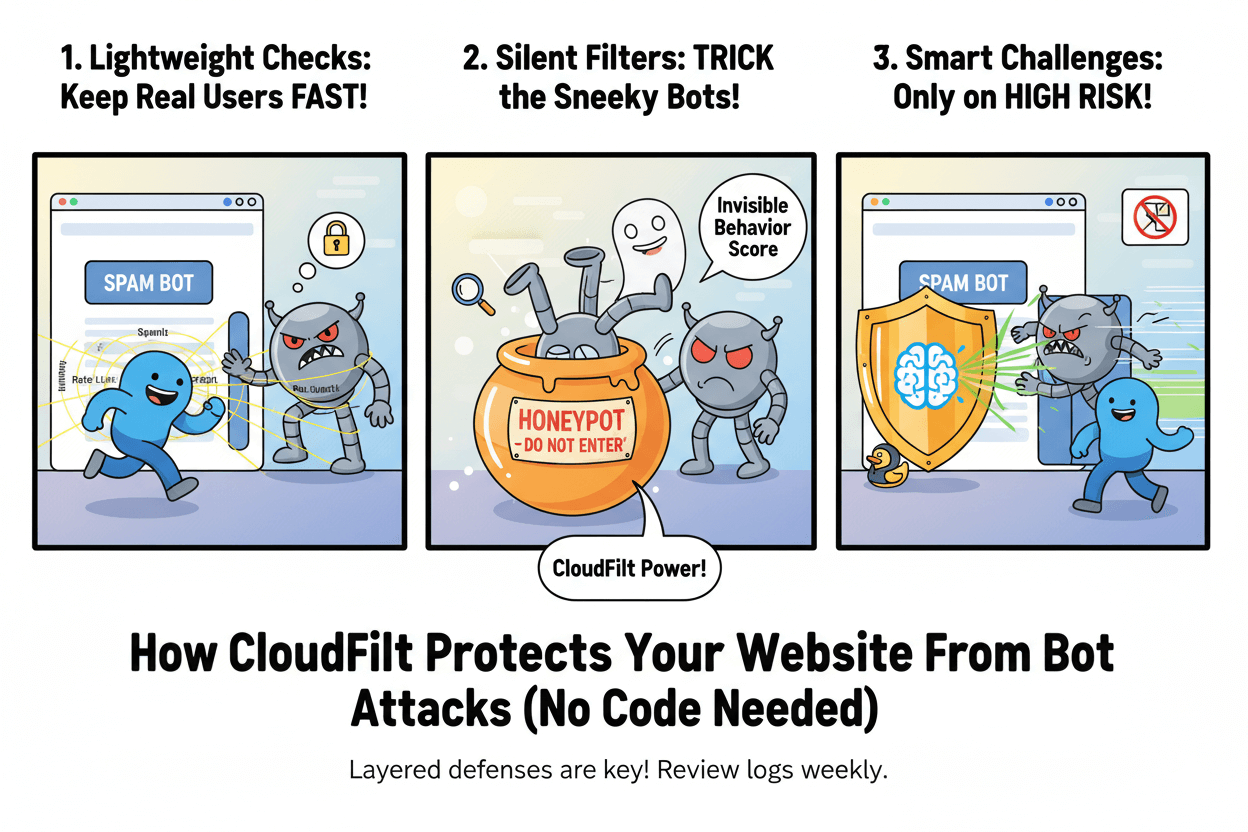

Endurecer los accesos y los moldes sin fricción

Abusa del acelerador y desafia solo en caso de riesgo. Haz que los usuarios reales sean rápidos.

Limitar los intentos de inicio de sesión y aplicar comprobaciones ligeras

Configura limitaciones de inicio de sesión y bloqueos temporales tras fallos repetidos. Progressive retrasa la adivinación de contraseñas y reduce la carga del servidor. Céntrate en /wp-login.php y /wp-admin/ Extremos.

Esto está alineado con las recomendaciones de OWASP y las prácticas de endurecimiento de WordPress.

En WordPress gestionado, límites de tasa como "~5 intentos fallidos en 5 minutos" por IP/nombre de usuario son referencias comunes; Sintoniza con tu audiencia y monitoriza el impacto.

Detener el spam de bots con tácticas de baja fricción

Haz que los usuarios reales sean rápidos. Combina la puntuación de comportamiento y las comprobaciones de antecedentes con filtros de spam silenciosos o honeypots antes de añadir cualquier desafío. Esto preserva la accesibilidad y reduce el abandono.

Las recomendaciones de proveedores y comunidad muestran que las opciones libres de CAPTCHA pueden bloquear grandes volúmenes de publicaciones automáticas de formularios.

Si el abuso persiste, escalar gradualmente: añadir desafíos ligeros solo en ráfagas sospechosas o agentes de usuario sin cabeza, no para todos.

Utiliza las reglas de país/ASN cuando los ataques se agrupan

Cuando los registros muestran intentos repetidos desde el mismo ASN o región, añadir limitaciones específicas o bloqueos temporales en lugar de desafíos globales. Esto centra la fricción cuando es justificada y limita el impacto colateral sobre los usuarios legítimos.

Combina estas reglas con pruebas de tu panel de bots y los registros del servidor.

Nota obligatoria: Ningún control único detiene a todos los atacantes. Usa defensas en capas y revisa los registros semanalmente.

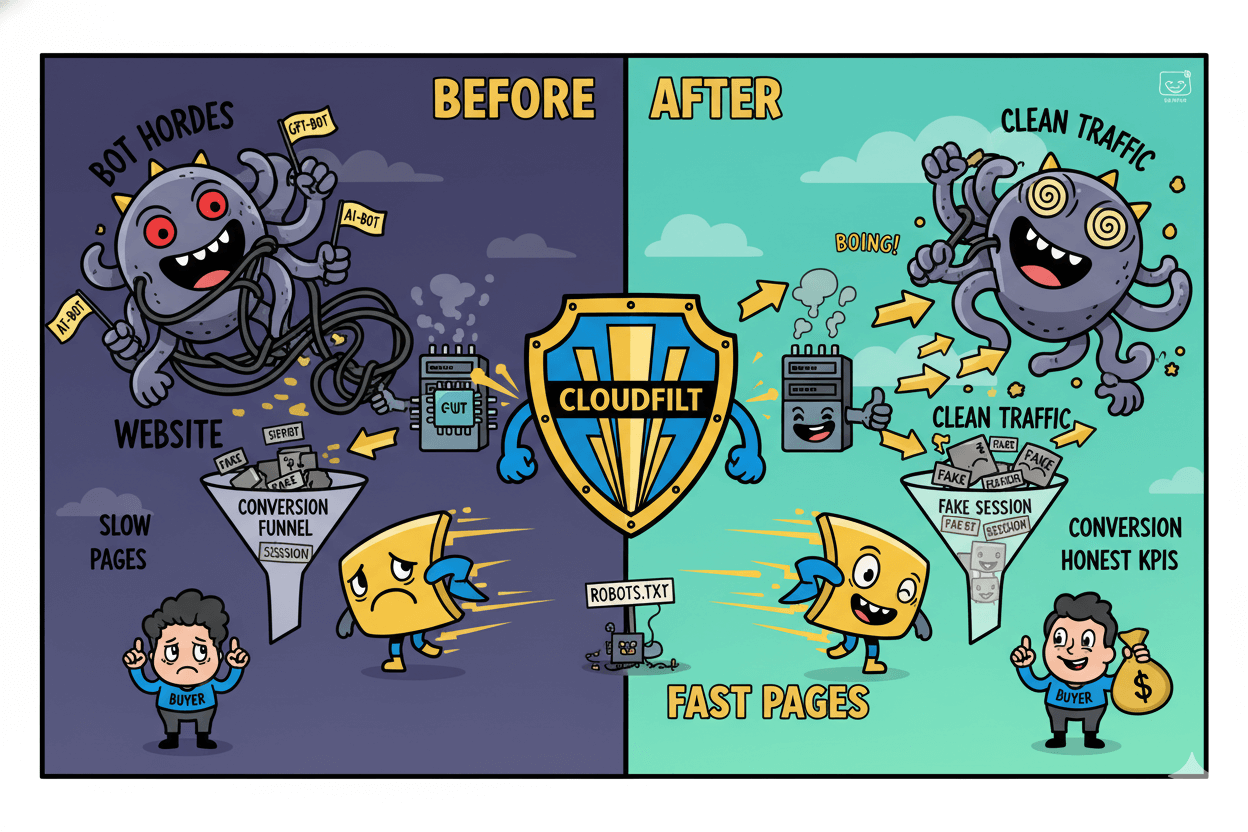

Tráfico limpio = páginas más rápidas y matemáticas de conversión más fieles

Reducir el desperdicio del rastreador libera ancho de banda y estabiliza los Vitales Web a medida que aumenta el rastreo de IA.

El ahorro de ancho de banda reduce el trabajo en servidores

El estudio de rastreo de Cloudflare de 2025 encontró que el tráfico de crawlers aumentó 18% interanual (mayo 2024→mayo 2025), con GPTBot subió un 305% . Ese aumento consume capacidad que debería servir a los compradores. Cuando los sitios bloquean o medirán rastreadores con mucho consumo, a menudo experimentan un gran alivio en el ancho de banda.

Un caso público de Read the Docs informó de un Caída del 75% en el tráfico después de bloquear bots de IA, guardar aproximadamente 1.500 dólares/mes Solo en ancho de banda. Resultado: menos picos en la cola, tiempos de respuesta más estables.

before_after: Si tienes hosting compartido o modesto, recortar las ráfagas del crawler puede suavizar la carga de la CPU y reducir los errores 5xx durante las promociones. Los hosters y CDNs advierten que el rastreo agresivo de IA sobrecarga los sitios pequeños en comparación con su tamaño.

Menos sesiones falsas levantan matemáticas de conversión

Las sesiones de bots diluyen la tasa de conversión, desequilibran los pasos del embudo y la atribución de inundación con ruido. Mientras los grandes proveedores se lanzan bloqueo por defecto de rastreadores de IA E incluso Pago por Crawl Controles, puedes decidir cuándo permitir, cargar o bloquear.

Limpiar el tráfico no "mágicamente" generará ingresos, pero sí hace que los KPIs sean honestos para que las victorias sean visibles y las pérdidas no estén ocultas por la niebla de bots.

myth_buster: Robots.txt ayuda a señalar la intención, aunque algunos rastreadores supuestamente Ignorar o esquivar esas reglas mediante IPs no declaradas o agentes de usuario intercambiados. Por eso las reglas del bot-manager y los límites de velocidad importan en la última milla.

Seguimiento de las constantes vitales web y las tasas de error tras los cambios

Demuestra el impacto con una tarjeta de puntuación ajustada. Reloj TTFB y LCP En plantillas clave mientras haces cumplir bloqueos o cargas. En paralelo, volumen de solicitudes de pistas, tasas 4xx/5xx, y Tasa de conversión .

Si los signos vitales mejoran y el ruido baja sin dañar a los buenos bots, estás en la configuración correcta. Revisar permitir/cobrar/bloquear cada mes; Las políticas y el comportamiento de los crawlers están evolucionando rápidamente.

Nota obligatoria: Ningún control único garantiza rendimiento o conversiones. Usa defensas en capas y revisa los registros semanalmente.

Demuéstralo: un plan de 7 días y KPIs

Referencia de hoy, primero monitorización, aplicación a mitad de semana, revisión al día siete. Decide permitir/cargar/bloquear.

Métricas de referencia a capturar hoy

Abre GA4. Confirmar Exclusión conocida del tráfico de bots es activa por diseño. No puedes desactivarlo ni ver que se eliminen las cantidades. Toma esto como algo que se puede pasar. Registra el tráfico actual, la interacción y las conversiones clave. Fíjate en TTFB y LCP de tu herramienta de rendimiento preferida.

Añadir filtros para Tráfico interno Así que las visitas a la consulta no distorsionan tu examen. Si haces hits de staging o QA, filtra también esos.

KPIs para registrar diariamente: Participación de bots en CloudFilt, volumen total de solicitudes, ancho de banda utilizado, recuento de formularios de spam, tasas de error, TTFB, LCP, tasa de conversión. Mantén una hoja sencilla. El objetivo es dirección y deltas, no ciencia perfecta desde el primer día.

Ritmo de revisión diaria para la primera semana

Días 1–2: Solo monitore. Compara los eventos de CloudFilt con los segmentos de GA4 para picos de interacción cero, picos fuera de horario y ASN repetidos. Verás patrones que GA4 no eliminó, porque solo filtra bots conocidos.

Días 3–5: Aplica el abuso claro. Empieza con límites suaves de tasa en el inicio de sesión y los feeds. Bloquea o desafía los análisis de urinas evidentes y los ASN agrupados. Estate atento a los errores y a las constantes de la web después de cada cambio.

Días 6–7: Compara antes y después. Quieres menor volumen de solicitudes, menos envíos de spam, TTFB y LCP más estables, y matemáticas de conversión más limpias. Si ves regresiones, revierte la última regla y vuelve a probar.

Decidir bloquear, permitir o cargar para los rastreadores de IA

La política está cambiando. Cloudflare ahora te permite establecer la política del rastreador por dominio: conceder , cargo o Bloquear a través de Pago por Crawl . Muchos clientes también lo han hecho bloqueo por defecto de rastreadores de IA excitado por los proveedores. Decide qué se adapta a tus objetivos y revisa cada mes.

Respuesta de la PAA dentro del plan: ¿Qué KPIs demuestran la reducción de bots y análisis más limpios? Busca bot share abajo, ancho de banda perdido, spam abajo, TTFB abajo, LCP abajo, tasa de conversión estable o alzada. Valida tendencias en GA4 mientras confirmas eventos en tu panel de bots.

Preguntas frecuentes y solución de problemas

Robots.txt es intención, no protección. Usa reglas y registros cuando los bots se porten mal.

Si robots.txt se ignora

Robots.txt es asesoramiento por diseño. Muchos rastreadores de confianza lo respetan, pero los agentes que no cumplen pueden omitirlo o falsificarlo. Trata a los robots como intento no protección , y se combinan con la aplicación de la ley.

Acción: Activar reglas de tasa de solicitud y desafíos de comportamiento en rutas y feeds de alto riesgo. Para abuso persistente, acelera o bloquea con ASN hasta que los patrones desaparezcan.

Evita bloquear en exceso a usuarios reales y buenos bots

Algunos rastreadores ahora están bloqueados por defecto en los principales proveedores, y existen nuevas opciones de "permitir / cargar / bloquear". Decide la póliza por cada rastreador y revisa cada mes. Mantén una lista corta de bots esenciales y tus compañeros.

quick_win: Si el rendimiento en las búsquedas importa, confirma que Googlebot, Bingbot y tu verificador de tiempo activo no se vean afectados tras los cambios en las normas.

Cuándo escalar con los registros

Cloudflare informa que Perplexity eludió las directivas de no rastreo mediante cambios de UA y ASN; La perplejidad contradice el análisis. Mantén pruebas objetivas antes de escalar: UAs ofensivos, rutas, marcas de tiempo y clústeres ASN/IP. Hechos actuales, no sentimientos.

Lo que s_and_don no hacer:

- Hacer Almacena entre 7 y 14 días de muestras antes de presentar un ticket.

- No Depender solo de los robots para los caminos sensibles.

- Hacer Rota los desafíos en lugar de bloques duros permanentes si el riesgo de garantía es alto.

Nota obligatoria: Ningún control bloquea todos los bots en solitario. Usa defensas en capas y revisa los registros regularmente.

Conclusión

Tienes un camino claro. Instala CloudFilt en WordPress, empieza en Monitor y luego aplica las normas donde el abuso sea evidente. El plugin oficial conecta tu sitio en minutos, y la franquicia gratuita de 3.000 solicitudes te permite demostrar el impacto antes de pagar.

Mide sobre la marcha. GA4 ya excluye automáticamente a los bots conocidos, pero el tráfico desconocido aún puede colarse. Haz una referencia base de GA4 y tus Web Vitals, compara los segmentos con eventos de CloudFilt y observa picos de cero interacción, picos fuera de horario y ASNs agrupados.

Cuando persisten los patrones, pasa de Monitor a aplicación dirigida.

Espera que el panorama siga moviéndose. La IA y los rastreadores de búsqueda crecieron rápidamente durante 2025, lo que explica por qué el ancho de banda y la precisión mejoran cuando se reducen las solicitudes de desperdicio.

Cloudflare ahora bloquea por defecto muchos rastreadores de IA y ofrece Pay Per Crawl para que puedas permitir, cobrar o bloquear según tus objetivos. Robots.txt sigue siendo útil como señal, pero no es suficiente por sí sola... Así que empareja las señales con la aplicación.

Ejecuta el plan de 7 días. Rastrea la compartición de bots, ancho de banda, recuento de formulario de spam, TTFB, LCP y tasa de conversión. Conserva lo que ayuda a los humanos a moverse más rápido y elimina lo que solo consumen las máquinas.

Mantén tu sitio sencillo, optimiza tus análisis y toma decisiones de marketing más inteligentes con facilidad.

CloudFilt: Protege tu sitio web hoy mismo

Aviso legal: Ningún control bloquea todos los bots. Usa defensas en capas y revisa los registros regularmente.